アップル、児童保護ページから「iCloudに保存された虐待画像の自動スキャン」を削除

Apple

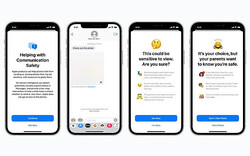

アップルは今年8月に児童虐待対策をiPhoneやMacに導入すると発表しましたが、対策の一つとしてCSAM(Child Sexual Abuse Material)、すなわちiCloudに保存される児童の性的虐待画像を自動的にスキャンする仕組みが含まれており、議論の対象となっていました。

しかしこのたび、同社が「児童に対する保護の拡大(Expanded Protections for Children」ページから全てのCSAMに関する記述を削除したことが明らかとなりました。

このiCloudに保存されるCSAM画像(iPhoneローカルではなく、クラウド保存される分のみ)の自動スキャンは、発表直後からセキュリティ研究者やエドワード・スノーデン氏、電子フロンティア財団(EFF)など幅広い個人や団体から批判を集めていました。

アップルは当初、懸念を払拭するために詳細な情報を公開し、公式FAQやドキュメント、幹部らのインタビューを通じて安心させようと試みていました。同社内でも「誤解されている」との戸惑いが渦巻き、それでも「説明を続ける」との社内メモが流出していたこともあります。

しかしアップルの努力にもかかわらず批判は収まらず、9月には導入の延期を発表しました。「お客様、利益団体、研究者などからのフィードバックに基づき(中略)さらに時間をかけることにしました」との声明を出すことを余儀なくされた次第です。

この声明も上記の「児童に対する保護の拡大」ページに追記されていましたが、16日現在ではCSAMに関する全ての言及が消されています。そのためアップルが恒久的に断念したのではないか、との憶測が持ち上がっていた格好です。

が、アップル広報はThe Vergeに対し、CSAM検出機能はWebサイトで言及しなくなったものの、計画は9月以降変わっていない。つまり将来的に実装する予定だ、との趣旨を述べています。

児童虐待対策はなくてはならない施策ではありますが、その一方で、たとえば「政府がアップルにCSAMではない画像をハッシュリストに追加するよう要求」つまり検閲のために悪用する恐れは、完全には否定しがたいと思われます。

今後アップルがさらに世論を説得するよう努力するのか、最終的に諦めるのか、展開を見守りたいところです。

Source:The Verge

via:MacRumors