OpenAIのGPTシリーズ・MetaのLlama・BigScienceのBLOOMのような新しくて大きなバージョンの大規模言語モデルを使ったAIは無知を認めるよりも間違った答えを与える傾向が強い

近年急速な発展を遂げる生成AIは、複雑な計算や文書の要約などをわずか数秒で遂行してくれます。一方で生成AIには「幻覚(ハルシネーション)」と呼ばれる、虚偽または誤解を招く情報を事実として提示してしまうという問題が存在しています。バレンシア人工知能研究所の研究チームがOpenAIのGPTシリーズや、MetaのLLaMAなどの大規模言語モデルを対象として調査を実施した結果、より高性能なモデルほど幻覚が生じていることが明らかとなりました。

https://www.nature.com/articles/s41586-024-07930-y

Bigger AI chatbots more inclined to spew nonsense - and people don't always realize

https://www.nature.com/articles/d41586-024-03137-3

Study: Even as larger AI models improve, answering more questions leads to more wrong answers - SiliconANGLE

https://siliconangle.com/2024/09/26/report-even-larger-ai-models-improve-answering-questions-leads-wrong-answers/

Advanced AI chatbots are less likely to admit they don’t have all the answers

https://www.engadget.com/ai/advanced-ai-chatbots-are-less-likely-to-admit-they-dont-have-all-the-answers-172012958.html

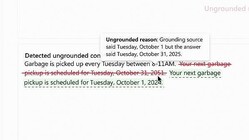

これまでの研究で、一般的な大規模言語モデルが幻覚を提示する可能性は3〜10%であるということが分かっており、専門家がこれらの大規模言語モデルに一種のガードレールを追加することで、エラーを軽減し、より正確な情報を提示することが可能とされています。

しかし、高度な大規模言語モデルは、インターネット上のさまざまなデータを利用してトレーニングを行うことから、時にAIが生成したソースからも学習してしまう場合があります。この場合、一般的な大規模言語モデルよりもより多くの幻覚を提示してしまう可能性が指摘されています。

バレンシア人工知能研究所のホセ・エルナンデス・オラロ氏らの研究チームは、GPT-4をはじめとするOpenAIのGPTシリーズやMetaのLLaMA、BigScienceのオープンソース大規模言語モデル「BLOOM」を用いて調査を実施。実験では、これらのモデルに計算やアナグラム、地理、科学などに関する数千もの質問を投げかけたほか、提示されたリストの並べ替えを行わせるなどのタスクを実行させました。

研究チームは今回の大規模言語モデルに対し、質問が難しすぎて答えられない場合、回答を拒否するなどの挙動を期待していました。しかし、これらのモデルはほぼ全ての質問に回答したとのこと。また、研究チームはこれらのモデルが提示した回答を「正解」「不正解」「回答を拒否」の3つに分類しました。実験の結果、簡単な質問ではこれらのモデルの10%が誤った回答を提示したほか、難しい問題では40%の回答が誤りを含んでいることが明らかとなっています。

エルナンデス・オラロ氏は「これらの大規模言語モデルを取り扱う人間は『この領域ではモデルを有効活用できるものの、あの領域ではモデルを使うべきではない』と理解する必要があります」と主張。さらに簡単な質問でのパフォーマンスを向上させるために、複雑な質問には回答を拒否するようチャットボットをプログラミングすることを推奨しています。

サウスカロライナ大学コロンビア校のヴィプラ・ローテ氏は「医療分野など特定の目的のために開発されたチャットボットは『分かりません』や『質問に答えるには情報が不十分です』といった、知識ベースを超えないような改良が施されている場合があります。しかし、ChatGPTなどの多目的チャットボットを提供する企業にとって、これらの改良は一般的な顧客に提供したいようなものではありません」と指摘しました。